机器学习基础

Chapter 1 绪论

section 1 基本术语

数据集: 记录的集合

示例, 样本: 数据集中的每一条记录

记录:属性, 特征 = 属性值

属性空间, 样本空间, 输入空间: 所有属性张成的空间

一般地,令维数。

学习, 训练: 从数据中学得模型的过程

训练数据: 训练过程中使用的数据

训练样本: 训练数据中的每一个样本

假设: 学得的模型对应数据的潜在规律

真相, 真实: 潜在规律自身

样例: 拥有标记信息的示例

section 2 假设空间

keyword:归纳学习,概念学习,版本空间

section 3 归纳偏好

归纳偏好:理解是对训练数据中的属性进行一个加权,将对于结果影响程度更大的属性优先考虑。

如何确定偏好呢?奥卡姆剃刀 (Occam’s razor) 是一种常用的、自然科学研究中最基本的原则,如果有多个假设与观察一直,就选择最简单的那个,并且假设我们认为的更平滑,也就是相似属性的样本标签相近,意味着更简单。

但是,无论学习算法 A 多聪明,学习算法 B 有多笨拙,他们的期望性能是相同的,这就是没有免费的午餐定理。(前提是所有问题重要性相同)

脱离具体问题,空泛谈论什么学习算法更好,毫无意义若考虑所有潜在问题,则所有学习算法都一样好,要谈论算法的相对优劣,必须要针对具体 的学习问题,学习算法自身的归纳偏好与问题是否匹配,往往会起到决定性的作用。

深度学习缺乏严格的理论基础,但是显著降低了机器学习应用者的门槛,为机器学习计数走向工程实践带来了便利。

Chapter 2 模型评估与选择

section 1 经验误差与过拟合

通常,将分类错误的样本数占总样本数量的比例称为”错误率“。如果在

相应的,将

一般的,将学习得到的预测输出与真实输出之间的差异称为”误差“。学习器在训练集上的误差称为”训练误差“或”经验误差“,在新样本上的误差称为”泛化误差“。

我们希望训练的时候,学习器能将样本中的一般规律给提取出来,但是,如果学习器将训练样本过度学习,将一些样本的”自身“特点当作普遍规律的时候,就会出现过拟合的现象,反之,如果对于训练样本的学习不充分,导致得到的普遍规律不明晰,没有学习到一般规律,就会导致欠拟合

一般而言,欠拟合比较容易客服,例如在决策树学习中扩展分支、在神经网络学习中增加训练轮数。而过拟合的处理就很麻烦,过拟合是无法彻底避免的,我们所能做的只是”缓解“,或者说减小其风险。机器学习面临的问题通常是 NP 难甚至更难,而有效的学习算法必然是在多项式时间内运行完成,如果可以彻底避免过拟合,则通过经验误差最小化就能获得最优解,意味着我们构造性地证明了”

section 2 评估方法

理想的解决方案当然是对候选模型的泛化误差进行评估,然后选择泛化误差最小的那个模型。但是我们无法直接获得泛化误差,而训练误差又由于过拟合现象的存在而不适合作为标准。

需要使用一个测试集来测试学习器对新样本的判别能力,然后以测试集上的测试误差作为泛化误差的近似。通常我们假设测试样本也是从样本真实分布中独立同分布采样获得的。但是,需要注意的是,测试集应该尽可能与训练集互斥,即测试样本尽量不在训练集中出现。

所以,需要将一个包含

几种常见的作法是:

- 留出法

直接将数据集划分为两个互斥的集合,其中一个集合作为训练集

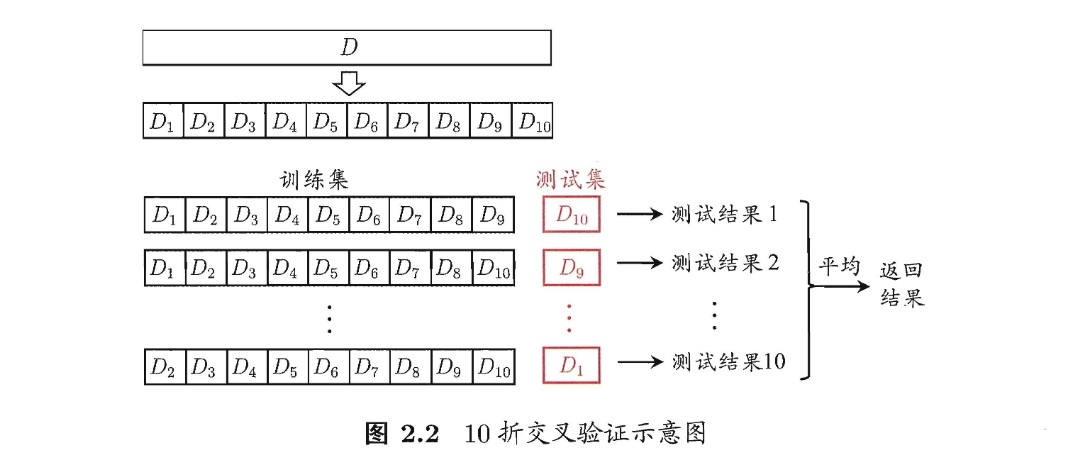

- 交叉验证法

先将数据集k折交叉验证。

- Title: 机器学习基础

- Author: Ryan Lu

- Created at : 2024-07-25 16:03:40

- Updated at : 2025-12-30 07:32:02

- Link: http://ryan-hub.site/176701b8f508/

- License: This work is licensed under CC BY-NC-SA 4.0.